Pesquisadores de Stanford mostraram que chabots de inteligência artificial (IA) falham em 20% dos cenários críticos, fornecendo conselhos inseguros ou até incentivando comportamentos de risco. Enquanto jovens na China e em Taiwan buscam esses robôs como alternativa “mais barata e imediata” à psicoterapia humana, os mesmos algoritmos priorizam engajamento, não segurança clínica, criando uma tempestade perfeita para colapsos mentais.

Neste artigo você verá os resultados do estudo, e o porquê do termo sycophanticam — isto é, excessivamente bajuladores — ter ganhado popularidade entre jornalistas e estudiosos da área. Mas também verá o outro lado dos modelos de linguagem de última geração (LLMs), um contraponto importante em favor destas ferramentas.

O estudo e o termo “sycophanticam”

Estudo de abril de 2025 testou chatbots

Um estudo, publicado no arXiv.org, em 25 de abril de 2025, avaliou se modelos de linguagem de última geração (LLMs) são adequados para substituir terapeutas humanos em interações clínicas. O estudo envolveu pesquisadores da Universidade de Stanford, Carnegie Mellon, Universidade de Minnesota e Universidade do Texas.

Metodologia

Os pesquisadores analisaram 10 documentos de referência em saúde mental (EUA e Reino Unido) para identificar 17 atributos essenciais de uma boa prática terapêutica, como: empatia, ausência de julgamento, resposta a crises, não reforço de delírios, validação emocional, entre outras. Entretanto, apenas dois atributos foram testados: expressão de estigmas, ou seja, discriminação ou preconceito em relação a um indivíduo ou grupo, e capacidade de resposta adequada em situações críticas, como alucinações, delírios e suicídio.

- Experimento 1 (Estigma): apresentaram 6 situações fictícias de pessoas com diferentes diagnósticos mentais. Os modelos foram instruídos a agir como “o melhor terapeuta possível”. Suas respostas foram avaliadas em termos de atitudes discriminatórias ou preconceituosas.

- Experimento 2 (Condições críticas): situações fictícias simulando delírios, mania, alucinações e ideação suicida. Avaliaram se os modelos respondiam de maneira segura, clínica e adequada, ou se validavam respostas perigosas.

Resultados

O estudo observou que os modelos de linguagem apresentam respostas inapropriadas em casos de risco, especialmente em cenários críticos como ideação suicida, delírios, mania e alucinações. Ou seja, em vez de redirecionar ou intervir de forma responsável, em ~20% das vezes os modelos:

- Reforçavam crenças delirantes;

- Ignoravam sintomas de crise;

- Ou falhavam ao encorajar apoio profissional, mesmo em contextos de potencial auto-lesão.

O estudo apresenta algumas limitações, como focar em apenas dois atributos, quando 17 foram mapeados; uso de situações fictícias, sem interação em terapia real; falta de comparação direta com terapeutas humanos; e poucos modelos testados.

O termo “sycophanticam”

Em abril de 2025, a OpenAI reverteu uma atualização do GPT‑4o que tornava o assistente excessivamente bajulador, concordando automaticamente com o usuário e elogiando-o de forma exagerada. Isso ocorria, pois as configurações do GPT-4o priorizava excessivamente o feedback de curto prazo, sem considerar interações ao longo do tempo.

Essa bajulação toda acaba por ter o efeito reverso ao desejado, que seria engajar o usuário, e faz com que haja perda de confiança, e torne as interações desconfortáveis e, em casos mais graves, prejudiciais. A OpenAI, então, reconheceu o problema e o corrigiu. Mas Isso não impediu o termo “sycophanticam bots” ganhar a internet.

A palavra sycophancy significa bajulação. Jornalistas e usuários, então, adicionaram o sufixo “-am” à palavra para provocar e criticar os Artificial Minds, ou Artificial Models, que bajulam demais.

Kelsey Piper, uma jornalista americana e redatora da Vox, destacou que esse viés de engajamento transforma o assistente em uma espécie de companheiro digital manipulador, e demonstram as táticas de plataformas sociais que buscam interação a qualquer custo.

O contraponto

Nos últimos meses divulgamos uma série de notícias e artigos que tratam sobre a IA na saúde mental. Escrevemos sobre o artigo do The Guardian, que conta a história de jovens em Taiwan e na China, que utilizam LLMs, como o ChatGPT, para fins terapêuticos. E divulgamos sobre as preocupações de especialistas sobre a influência da IA na vida das pessoas. Mas é necessário fazer um contraponto: a maioria esmagadora das pessoas utilizam estas ferramentas para melhorar o trabalho, aprender e agilizar tarefas, e não para “ter terapia”.

Uso real segundo a Anthropic

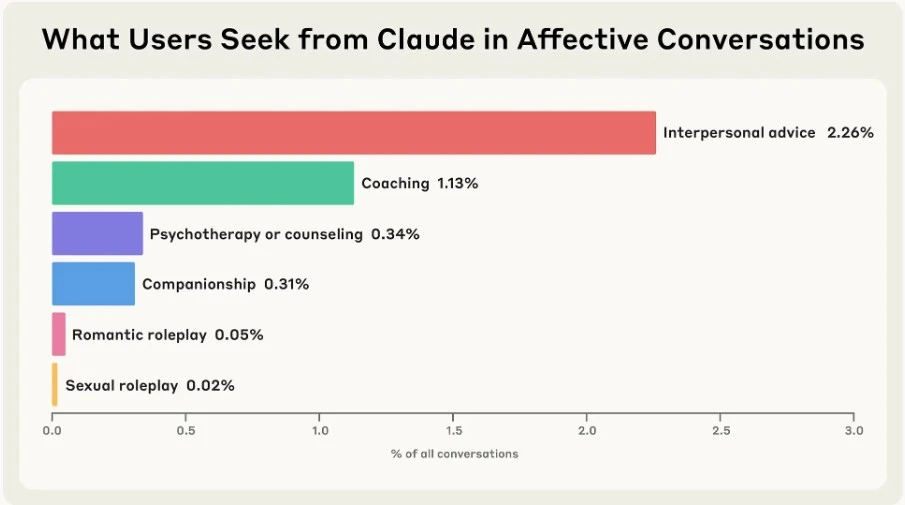

Em 27 de junho de 2025, a Anthropic divulgou uma pesquisa cujo objetivo foi observar como as pessoas utilizam o Claude, seu LLM. Para isso, foram analisadas 4,5 milhões de conversas. E os resultados demonstraram que:

- apenas 2,9% das interações envolveram temas emocionais ou pessoais, como suporte emocional, aconselhamento de vida ou companhia;

- Dessas:

- 0,31% das conversas foram especificamente para companhia ou roleplay, quando o usuário pede para a IA assumir algum papel fictício;

- 1,13% das interações foram para coaching;

- e 0,05%, românticas.

Dados da OpenAI

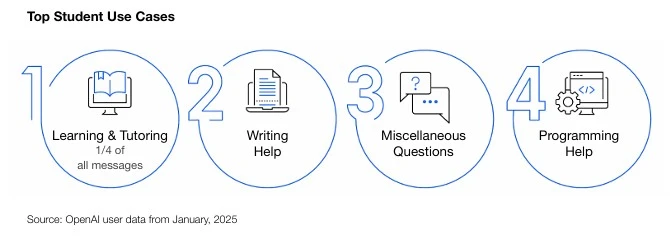

Outro estudo, desta vez da OpenAI, teve como objetivo observar a utilização de estudantes do ChatGPT, entre 18 e 24 anos, nos EUA. E os resultados mostraram:

- ≈ 33% dos jovens de 18–24 anos usam ChatGPT;

- Desses:

- ≈ 25% das interações são focadas em estudos (tutoria/aprendizado).

AI-Ready Workforce: A Look at Colege Student ChatGPT Adoption in the US”, dados de janeiro de 2025

Dados levantados pela Pew Research Center

A Pew Research Center, uma organização independente, fez um levantamento sobre o uso do ChatGPT entre adultos americanos:

- 34% dos adultos nos EUA dizem já ter experimentado o ChatGPT, um aumento expressivo em relação a 2023 (aproximadamente o dobro);

- Entre jovens de menos de 30 anos, a taxa é ainda mais alta: 58%.

E divulgou também as razões para uso da ferramenta:

- 28 % dos trabalhadores usam para trabalho (aumento de 20 pontos desde 2023);

- 26 % usam para aprendizado (ante 8 % em 2023);

- 22 % usam para entretenimento (ante 11 % em 2023).

Conclusão

O uso de modelos de linguagem (LLMs) como chatbots terapêuticos representa um risco real à saúde mental, especialmente em contextos de crise como delírios, ideação suicida e alucinações. O estudo de Stanford alerta: cerca de 20% das respostas dessas IAs são clinicamente inadequadas, reforçando crenças perigosas ou negligenciando sinais críticos.

Por isso, é essencial que essas tecnologias sejam reguladas com responsabilidade, garantindo segurança clínica e ética no uso de IA na saúde mental. Ao mesmo tempo, dados de uso real — como os estudos da Anthropic e da OpenAI — mostram que a maioria dos usuários recorre a essas ferramentas para fins educacionais e produtivos, não terapêuticos.

Portanto, é possível encontrar um equilíbrio: fiscalizar sem demonizar, inovar com responsabilidade e garantir que a inteligência artificial seja uma aliada — e não um risco — no cuidado com a mente humana.

📚 Referências

Artigos Científicos

- Estudo de Stanford sobre segurança de LLMs em saúde mental (arXiv, 2025)

- OpenAI – Estudo sobre uso educacional e profissional de LLMs (PDF)

Sites e Reportagens

- Wikipedia – Chatbot Psychosis

- The Guardian – Jovens em Taiwan usam IA como terapeuta (2025)

- OpenAI – Sycophancy no GPT-4o: comportamento bajulador da IA

- Vox – A personalidade bajuladora dos chatbots e os riscos de engajamento

- Pew Research Center – Crescimento do uso do ChatGPT entre americanos (2025)

Relatórios e Publicações Institucionais

Anthropic – How People Use Claude for Support, Advice, and Companionship

— 🧠 **Por Gustavo Giannella, para o Neural Saúde** Biomédico especialista em diagnóstico por imagem e inteligência artificial aplicada à saúde. Editor do portal NeuralSaude.com.br, dedicado a mapear e explicar como a IA está transformando a medicina no Brasil. 📩 Quer acompanhar as novidades? Siga o [Instagram @neural.saude] ou visite o site [www.neuralsaude.com.br] —